Un grupo de mujeres alojadas en el Polo de la Mujer denunció presuntas situaciones de maltrato, restricciones y entrega de alimentos en mal estado dentro del anexo.

Mrinank Sharma, responsable de Salvaguardas en Anthropic, dejó una pregunta flotando: ¿qué tan seguros son realmente los modelos de IA que usamos a diario?

12 de febrero de 2026 AA PRENSA

AA PRENSA

Mrinank Sharma, quien hasta el 9 de febrero se desempeñaba como responsable de Salvaguardas en Anthropic, presentó su renuncia a través de una carta en la que destaca los desafíos éticos y la integridad dentro de las organizaciones tecnológicas y advierte: “El mundo está en peligro por la inteligencia artificial”

¿Qué es Anthropic?

Para entender el impacto de esta renuncia, es necesario precisar qué representa esta compañía en el mapa tecnológico actual. Anthropic es una empresa de seguridad e investigación en inteligencia artificial con sede en San Francisco, fundada en 2021 por exmiembros de OpenAI, los creadores de ChatGPT.

La firma nació con una misión específica: desarrollar sistemas de IA que sean confiables, interpretables y seguros. A diferencia de otros competidores, Anthropic se posicionó rápidamente como la opción ética del mercado, ya que promovía un método para entrenar modelos que se basaba en principios y valores humanos predefinidos. Su chatbot más conocido, Claude, es hoy el principal rival de ChatGPT y las herramientas de IA de Google y Microsoft.

“El mundo está en peligro”

En su carta de despedida, publicada en X, Sharma realizó un balance de sus dos años en la compañía, donde trabajó en áreas críticas como la detección de la adulación en la IA (cuando el sistema miente para complacer al usuario) y la creación de defensas contra el bioterrorismo asistido por algoritmos.

Sin embargo, el núcleo de su mensaje no es técnico, sino profundamente humano y filosófico. El investigador planteó una visión alarmante sobre el estado actual de la tecnología: “El mundo está en peligro. Y no solo por la IA o las armas biológicas, sino por una serie de crisis interconectadas que se desarrollan en este mismo momento”.

Según Sharma, la humanidad está alcanzando un umbral donde la sabiduría de las personas debe crecer en igual medida que la capacidad para afectar al mundo, y advirtió que, de no ser así, enfrentaremos consecuencias inevitables.

Uno de los puntos más críticos de su carta es la mención a las dificultades internas para mantener los valores en una industria que corre a contrarreloj. Sharma confesó haber visto, tanto en sí mismo como en la organización, las presiones constantes para dejar de lado lo que realmente importa en favor de otros objetivos.

Su proyecto final en la empresa fue, quizás, el más simbólico: una investigación sobre cómo los asistentes de inteligencia artificial podrían hacernos menos humanos o distorsionar nuestra humanidad.

Sobre su futuro, Sharma confesó que su intención es alejarse de las estructuras que lo sostuvieron estos años para explorar la verdad poética junto a la verdad científica.

Tras su salida, el investigador confirmó que regresará al Reino Unido para iniciar un período de bajo perfil y volverse invisible por un tiempo, enfocándose en el estudio de la poesía, la escritura y la construcción comunitaria.

Su renuncia deja una pregunta incómoda flotando en Silicon Valley: si el responsable de protegernos de la IA considera que el sistema actual no permite actuar con integridad, ¿qué tan seguros son realmente los modelos de inteligencia artifical que usamos a diario?

Un grupo de mujeres alojadas en el Polo de la Mujer denunció presuntas situaciones de maltrato, restricciones y entrega de alimentos en mal estado dentro del anexo.

Este miércoles, finalmente, inició el juicio contra el exintendente de San Lorenzo, Ernesto “Kila” Gonza. Es el segundo proceso penal que deberá afrontar.

El Servicio Meteorológico Nacional emitió un alerta amarillo por tormentas para distintos departamentos de la provincia. Se prevén lluvias intensas, ráfagas y posible caída de granizo.

Tras relevar cortes, baja presión y altos niveles de turbiedad en el servicio de agua potable, el Ente Regulador de los Servicios Públicos dispuso que los usuarios afectados no abonen la tarifa durante los días de incidencia y exigió garantizar la provisión alternativa del recurso.

La sesión está convocada para las 11. Hubo 28 modificaciones negociadas con bloques aliados y mandatarios provinciales, con el objetivo de lograr la media sanción. Afuera, los gremios protestarán contra la iniciativa.

Ocurrió en la intersección de Luro y España. Uno empuñaba un cuchillo mientras que el otro lo amenazaba con el filo de una botella rota.

La conductora volvió a explotar contra la actriz y hasta Pampita fue salpicada en este nuevo escándalo.

El presidente fue acusado por el director nacional del Ministerio de Seguridad y socio del Xeneize, Walter Klix. En agosto del año pasado, la Justicia ya había archivado una presentación similar.

Para todos los papás que ya están buscando precios para el inicio del año lectivo 2026 Multivisión te muestra toda la variedad de precios de los útiles.

El oficialismo logró el quórum con 38 senadores pese a la ausencia del peronismo y legisladores de Santa Cruz. El Gobierno aceptó más de 20 modificaciones al proyecto original para asegurar los apoyos necesarios.

Un socio activo presentó una denuncia penal en la Justicia federal por supuesto manejo irregular de fondos, entradas y padrón de socios. La causa quedó radicada en el Juzgado Federal N°39 y se encuentra en etapa preliminar.

Con apoyo del PRO, la UCR y bloques provinciales, La Libertad Avanza reunió 81 firmas en comisiones. El proyecto fija la punibilidad desde los 14 años y establece penas máximas de 15 años para delitos graves.

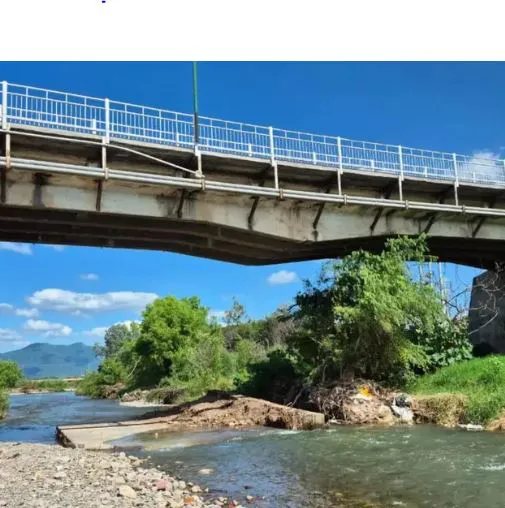

Tras ceder un pilote, la actual gestión cuestionó la obra realizada en 2020 y advirtió posibles irregularidades entre lo informado y lo ejecutado.